Peut-on quantifier la conscience ?

La théorie de l'information intégrée est une thèse audacieuse qui prétend mesurer le degré de conscience d'un système au moyen d'une formule mathématique.

En ce moment même, vous êtes en train de lire ces lignes. Des photons frappent votre rétine, des signaux électriques parcourent vos neurones, et quelque part dans ce processus, il y a quelque chose que cela fait d’être vous. Une expérience subjective, un « effet que ça fait » de voir ces mots, peut-être accompagné d’une légère curiosité ou d’un début de fatigue.

Cette dimension intérieure de l’expérience, ce que les philosophes appellent la conscience phénoménale, est l’un des mystères les plus profonds qui soient.

Depuis quelques décennies, les neurosciences ont fait des progrès considérables dans l’étude de ce qu’on appelle les corrélats neuronaux de la conscience, c’est-à-dire la compréhension des états cérébraux qui accompagnent les expériences conscientes. Le sommeil profond, l’anesthésie générale ou certains comas, nous privent de conscience alors que notre cerveau continue de fonctionner, mais qu’est-ce qui diffère ?

La théorie dominante aujourd’hui, la théorie de l’espace de travail neuronal global (abrégé GNWT en anglais), propose une réponse : nous sommes conscients d’une information lorsqu’elle devient disponible dans un « espace de travail » global, une sorte de théâtre partagé, accessible à l’ensemble de nos fonctions cognitives comme la mémoire, le langage, la planification, ou l’action.

Mais pour le philosophe David Chalmers, ce type d’explication passe à côté de quelque chose d’essentiel. Expliquer quand et comment certaines informations deviennent globalement accessibles, c’est ce qu’il appelle le problème facile (« facile » non pas parce qu’il est simple, mais parce qu’il relève de méthodes scientifiques classiques.)

Pour Chalmers, le problème « difficile » de la conscience est ailleurs : pourquoi ces processus cérébraux s’accompagnent-ils d’une expérience subjective ? Pourquoi n’y a-t-il pas « rien que cela fait » d’être un cerveau qui traite de l’information ? Chalmers illustre ce point par l’expérience de pensée du zombie philosophique : peut-on concevoir un être physiquement en tout point semblable à vous, se comportant de façon identique à vous, mais totalement dépourvu d’expérience intérieure ? Si oui, alors l’expérience consciente n’est peut-être pas réductible aux processus fonctionnels.

C’est précisément ce problème difficile que la théorie de l’information intégrée (ou IIT en anglais) prétend affronter. Plutôt que de chercher les corrélats neuronaux de la conscience, elle part de l’expérience consciente elle-même et demande : quelles propriétés un système physique doit-il posséder pour être conscient ? Sa réponse, audacieuse et controversée, est que la conscience n’émerge pas de certains processus : elle est une propriété fondamentale de certains systèmes, quantifiable mathématiquement.

La théorie de l’information intégrée

L’objectif de la théorie de l’information intégrée (IIT) est de proposer un cadre d’analyse mathématique permettant, à partir des propriétés fondamentales d’un système comme sa structure et sa dynamique d’évolution, de lui attribuer un nombre qui quantifie son degré de conscience.

Sur le papier, on peut imaginer de nombreuses de façon de le faire, mais le défi consiste à en concevoir une qui soit a minima conforme avec nos intuitions sur ce qu’est la conscience, et sur les systèmes susceptibles d’en posséder une.

Pour cela, Giulio Tononi, le père de la théorie de l’IIT, dresse d’abord une série d’axiomes — je ne suis pas sûr que le terme soit bien choisi ! — qui correspondent pour lui à des propriétés évidentes de notre expérience consciente. Par exemple toute expérience est unifiée (on ne peut pas avoir une « demi-expérience »), et toute expérience est spécifique (c’est cette expérience-ci, pas une autre).

Ensuite, Tononi s’efforce de traduire ces axiomes en propriétés que les structures des systèmes physiques « conscients » devraient nécessairement posséder. Cette analyse lui permet alors de chercher une quantité mathématique qui semble satisfaire les propriétés recherchées. Comme son nom l’indique, l’IIT se propose d’utiliser l’information intégrée.

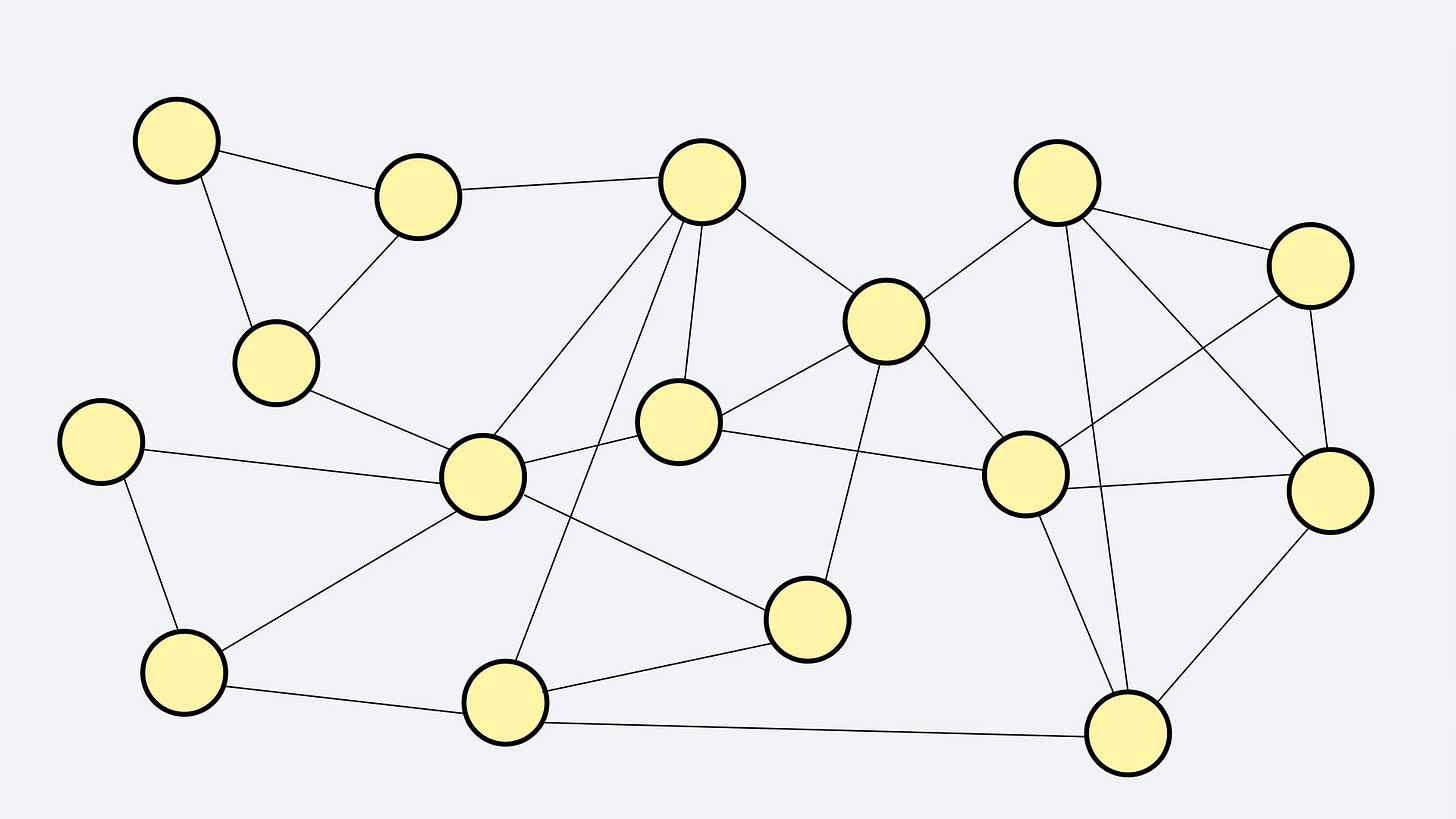

Pour comprendre cette notion, imaginez un système S dont vous vous demandez à quel point il est conscient ou non. Supposons que ce système soit constitué d’un grand nombre d’unités élémentaires en contact les unes avec les autres, et qui donc s’influencent mutuellement.

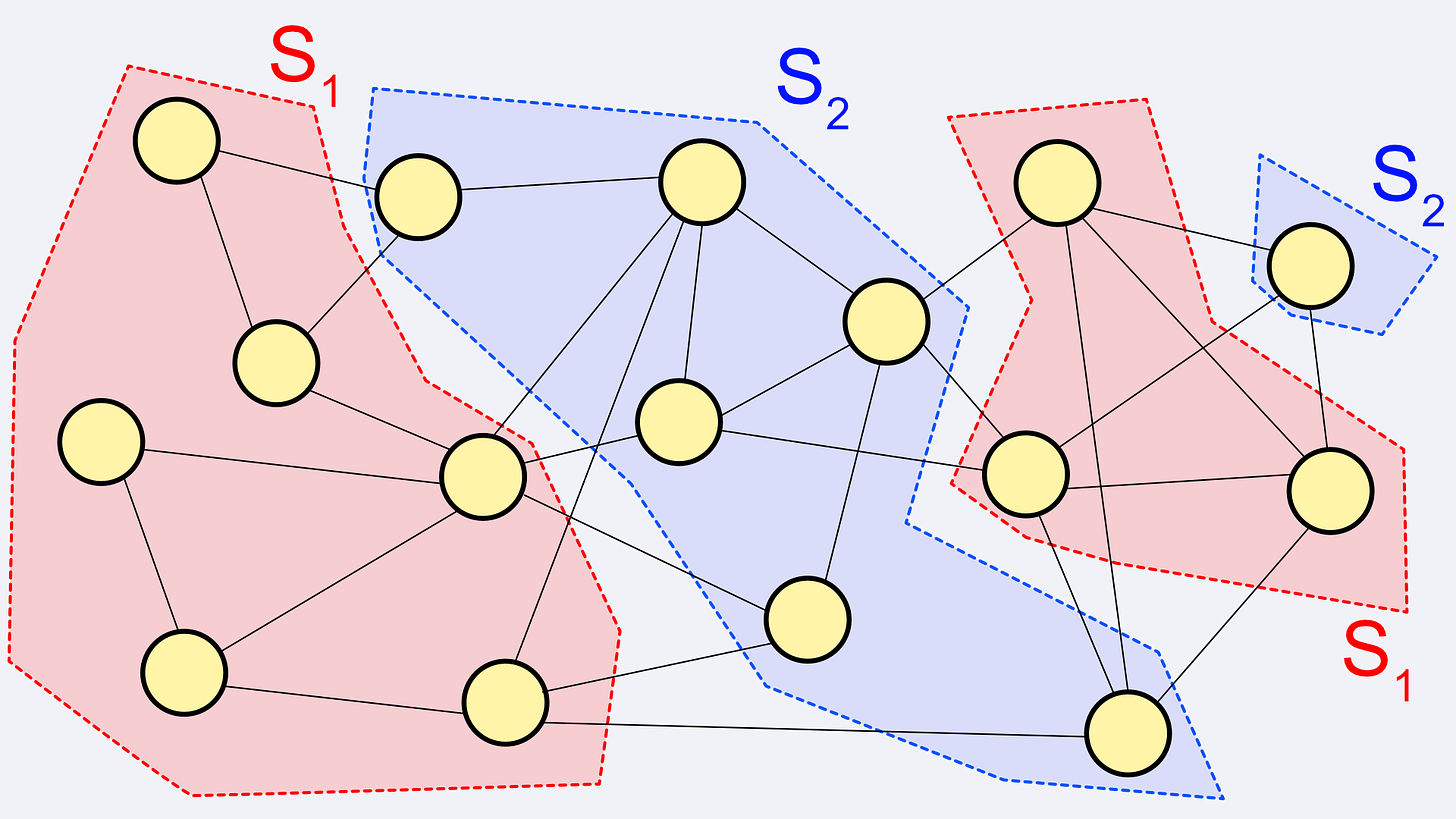

Maintenant séparez mentalement ce système en deux sous-parties S1 et S2. Vous pouvez le faire de la manière que vous souhaitez, mathématiquement, on réalise une partition de S en deux sous-parties S1 et S2.

Ensuite, imaginez que l’on supprime les connexions causales entre S1 et S2, c’est-à-dire toutes les liaisons qui relient une unité de l’un à une unité de l’autre. Une fois cette partition effectuée, on se demande à quel point le nouveau système constitué de S1 et S2 est différent du système original S. A quel point se trouve-t-il modifié dans sa dynamique et dans sa façon de fonctionner ? Ou bien de manière équivalente, à quelle point les connexions entre S1 et S2 jouaient un rôle important dans la dynamique du système S.

On peut imaginer de nombreuses façon de quantifier cette notion. (Pour ceux qui aiment les probas, on peut penser par exemple à quelque chose comme l’information mutuelle entre S1 et S2). Les détails exacts de l’ITT dans sa version actuelle sont un peu compliqués, mais il n’est pas critique à ce stade de les spécifier tous.

Imaginons donc que l’on dispose d’une mesure de l’impact d’une partition du système en S1+S2, et notons là

Plus φ est élevé, plus les sous-parties S1 et S2 ont des liens entre elles, plus elles partagent de l’information, et donc plus ces liens sont importants dans la dynamique globale de S.

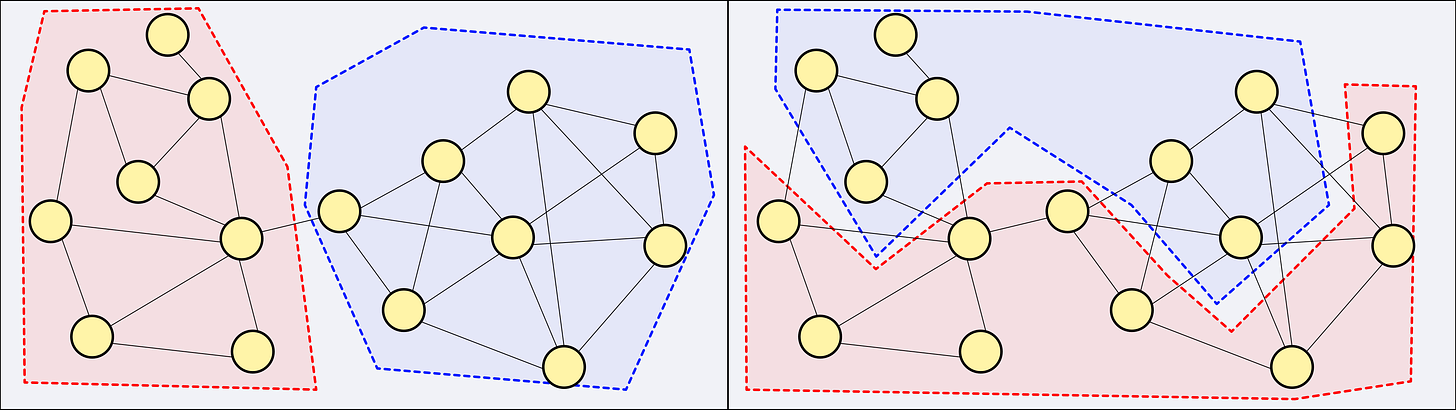

Si l’on prend un système concret, on imagine volontiers que certaines partitions en S1+S2 conduiront à un φ élevé, et d’autres moins. Par exemple si S est constitué de deux sous-systèmes ayant peu de communication entre eux, partitioner S précisément de cette façon devrait conduire à un φ plus faible que de le partitioner au hasard.

La théorie de l’information intégrée propose alors de sélectionner la partition qui conduit au φ(S1,S2) le plus faible, et de noter Φ (majuscule) la valeur correspondante. Il s’agit de la valeur de l’information partagée dans le cas de la partition la plus bénigne, la moins impactante.

L’idée derrière ce choix est qu’un Φ élevé indique un système extrêmement intégré, pour lequel chaque partie dépend de toutes les autres; un système au sein duquel il existe de nombreuses relations causales, telles qu’il est impossible de le partitioner en deux sans en perdre l’essence.

Cette définition semble bien répondre à l’intuition que nous avons de la conscience : un système a d’autant plus de chances d’être conscient qu’il est complexe et très connecté. Mais pour autant, la seule complexité ne fait pas tout si le système est facilement séparable en sous parties presque indépendantes.

Prenons l’exemple d’un système constitué de deux personnes réunies dans une pièce et en train d’avoir une discussion. Ce système est a priori plus complexe qu’une seule personne, et pourtant il est facilement séparable en deux sous-systèmes partageant peu d’informations. Le système constitué des deux personnes aura donc un Φ faible, ce qui est cohérent avec notre intuition que les individus sont conscients, mais qu’il n’existe pas de “super-conscience” associée à une réunion d’individus.

Voici les principes mathématiques de l’IIT dans les grandes lignes. Mais notez bien que ce que je vous ai décrit ici est une version très rudimentaire du cadre quantitatif proposé par l’IIT. Il existe plein de subtilités dans la façon de découper, de mesurer mathématiquement l’information intégrée, de prendre en compte la notion de causalité, de la faire dépendre de l’état du système, etc. L’IIT propose aussi que les systèmes doués d’expériences conscientes sont ceux qui ne possèdent aucun sous-système ni aucun sur-système disposant d’un Φ plus élevé.

Si les détails vous intéressent, je vous renvoie par exemple au wiki mis en place par les tenants de l’IIT. Donc ne vous fiez pas à ma description pour tout comprendre, mais l’essence de l’idée est là : si on dispose d’un système, de son état actuel, de sa dynamique, on peut lui associer une valeur d’information intégrée Φ en minimisant une certaine quantité sur l’ensemble des partitions possibles du système.

Que faire de ça ?

En pratique, il est très compliqué de calculer exactement Φ. Il faut disposer d’une description microscopique du système et de sa dynamique, considérer toutes les partitions possibles pour trouver la plus favorable. Pour un système constitué de N unités élémentaires, il y a 2^N partitions possibles; et pour chacune de ces partitions il faut calculer un φ afin de trouver le minimum. On y arrive de façon exacte seulement sur des systèmes modèles constitués de quelques unités élémentaires, et décrits par des règles de transition connues explicitement.

Le principe du calcul de l’information intégré reste donc très conceptuel et pas très pratique. (Mais vu que j’ai passé mes années de thèse en physique à manipuler « la fonction d’onde de l’Univers » comme une intégrale de chemin sur tous les trajectoires possibles de l’espace-temps, je suis mal placé pour critiquer les formulations conceptuelles à base de quantités incalculables en pratique !)

Malgré l’intractabilité apparente du calcul de Φ pour les systèmes réels (disons un cerveau), il existe des façons approchées de l’estimer, et qui permettent de faire des prédictions testables concernant notamment l’association entre les états de conscience et l’activité cérébrale.

Par exemple, l’IIT justifie qu’une région comme le cervelet n’aurait que peu de rôle dans les phénomènes conscients malgré sa complexité et son importance fonctionnelle. En effet le cervelet aurait une structure très modulaire auquel serait associé naturellement un Φ faible.

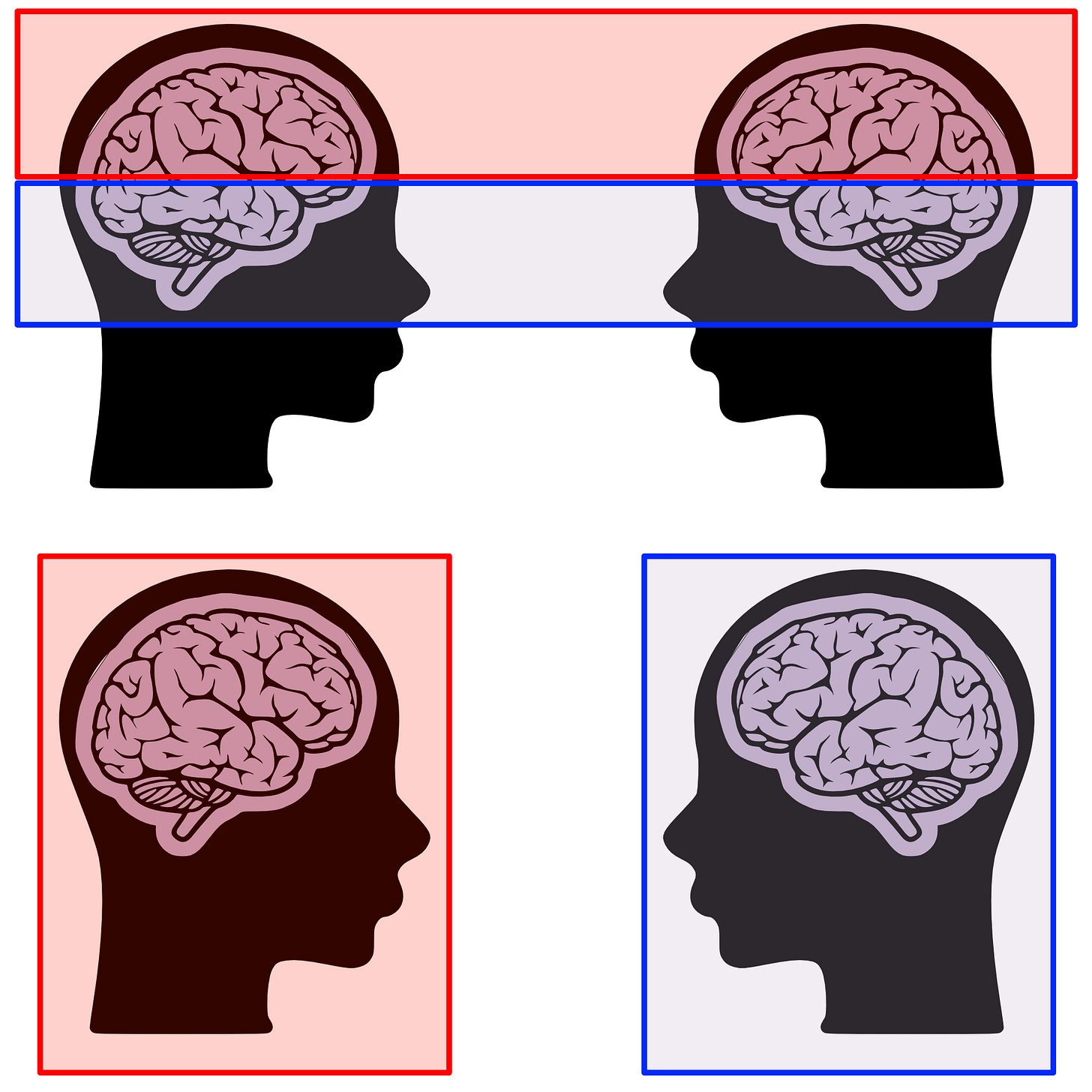

Plus surprenant, l’IIT prédit que certaines régions postérieures du cerveau joueraient un rôle essentiel dans les processus conscients, là où la théorie de l’espace de travail global privilégie plutôt le cortex pré-frontal. Voici des prédictions différentes a priori testables !

Une collaboration « adversariale »

En 2023, les principaux tenants des théories IIT et GNWT ont décidé de collaborer pour mettre à l’épreuve leurs thèses, en formant le consortium COGITATE. Ils se sont mis d’accord sur un protocole expérimental, et sur trois éléments essentiels sur lesquels les théories GNWT et IIT faisaient des prédictions différentes. Pour éviter toute interprétation ad hoc a posteriori, ils ont alors pré-enregistré leurs prédictions avant que les expériences ne soient réalisées. C’est ce qu’on appelle une collaboration adversariale. Et c’est — me semble-t-il — une belle façon honnête de faire de la science !

Dans cette série d’expériences, 256 participants ont été soumis à divers stimuli, et leur activité cérébrale a été mesurée au moyen de différents instruments : l’IRM fonctionnelle, la magnéto-encéphalographie (MEG), et l’électro-encéphalographie intracrânienne. En juin 2025, la revue Nature a publié les résultats définitifs de cette étude.

Cogitate Consortium., Ferrante, O., Gorska-Klimowska, U. et al. Adversarial testing of global neuronal workspace and integrated information theories of consciousness. Nature 642, 133–142 (2025). https://doi.org/10.1038/s41586-025-08888-1

Il serait un peu long de résumer l’ensemble de l’article, mais disons que les conclusions en sont plutôt nuancées. Les observations sont en partie conformes avec certains aspects des deux théories, mais aussi bien l’IIT que la GNWT se trouvent mises en défaut par certains résultats.

Pour l'IIT, le défi principal est l'absence de synchronisation soutenue au sein du cortex postérieur, une prédiction pourtant centrale de la théorie. Pour GNWT, c'est l'absence d'« ignition » dans le cortex préfrontal à la disparition du stimulus : quand une image s'efface et qu'un écran vide apparaît, l'expérience consciente change, mais l'activité préfrontale prédite par GNWT n'apparaît pas.

Si l’on voulait résumer l’article par une formule à l’emporte-pièce, on dirait « match nul », mais ce serait ramener ces études passionnantes à un simple affrontement sportif, et la science mérite mieux que ça !

Le point le plus marquant pour moi dans cette collaboration et ces résultats, c’est que l’IIT — un temps considérée comme une théorie fantasque — se trouve maintenant plus légitime à prétendre être une candidate sérieuse…C’est donc a minima une victoire de respectabilité pour l’IIT. Et pourtant elle porte en elle certaines implications plutôt dérangeantes !

Les thermostats sont-ils conscients ?

Une première caractéristique étonnante de l’IIT, c’est qu’elle va associer un Φ non nul (et donc un certain degré de conscience) a des systèmes dynamiques même tous petits, par exemple un thermostat. Cette idée que presque tous les systèmes matériels puissent être le siège d’une forme minimale de conscience porte un nom : le panpsychisme.

L’idée de panpsychisme n’est pas nouvelle en philosophie de la conscience, on la retrouve chez plusieurs auteurs comme Leibniz ou le logicien Whitehead. Mais la plupart des philosophes l’ont longtemps considérée comme peu sérieuse.

Pour certains, l’implication panpsychique est donc un problème majeur de l’IIT, puisqu’on aurait envie de penser que de façon évidente, un thermostat n’est pas conscient. Et pourtant il faut préciser deux choses qui permettent à mon avis de relativiser cette conclusion troublante.

Tout d’abord les ordres de grandeur sont tels qu’un système comme un cerveau humain possèderait un Φ incommensurablement plus élevé que celui d’un thermostat. On est donc bien sur quelque chose de négligeable pour le thermostat. D’autre part, je trouve l’idée d’un continuum au contraire naturelle. C’est plutôt l’existence d’une frontière nette entre conscience et non-conscience qui me semble difficile à avaler. Dans la mesure où l’on sait imaginer des tas de systèmes plus petits que le cerveau humain, je ne vois pas très bien à partir de quand on passerait abruptement du conscient au non-conscient. Nous avons environ 80 milliards de neurones, le ver nématode C. Elegans n’en a que 302. Y aurait-il un nombre minimal de neurones à posséder pour prétendre être doué d’un minimum de conscience ? Où se situerait la frontière ?

A l’encontre du fonctionnalisme

Une autre implication plus technique mais fascinante de l’IIT concerne sa posture anti-fonctionnaliste. En philosophie de l’esprit, le fonctionnalisme est une position très influente : elle affirme que ce qui rend un système conscient, c’est la fonction qu’il réalise, c’est-à-dire les relations entre ses entrées et ses sorties. Une conséquence majeure du fonctionnalisme, c’est l’indépendance vis-à-vis du substrat : si un système de silicium réalise exactement les mêmes fonctions qu’un cerveau biologique, il devrait être tout aussi conscient.

L’IIT rejette cette conclusion. Ce qui compte pour elle, ce n’est pas seulement la fonction entrée/sortie, mais la structure causale interne, la façon dont les parties du système s’influencent mutuellement. Deux systèmes peuvent avoir un comportement extérieur identique tout en ayant des architectures internes radicalement différentes, et donc des valeurs de Φ possiblement très éloignées.

L’exemple le plus frappant est celui de la table de correspondance : imaginez un système qui, pour chaque entrée possible, consulte une gigantesque table précalculée et renvoie la sortie correspondante. En principe, une telle table pourrait reproduire presque parfaitement une grande partie du comportement d’un cerveau humain. Mais sa structure interne n’a aucune intégration : chaque consultation est indépendante des autres, Φ est essentiellement nul. Selon l’IIT, ce système n’aurait aucune conscience, malgré un comportement identique.

Même au sein des réseaux de neurones artificiels, l’architecture compte : un réseau purement feedforward (où l’information circule dans un seul sens) aurait un Φ plus faible qu’un réseau récurrent, où les connexions de rétroaction créent des dépendances mutuelles entre les parties.

Cette position a des implications vertigineuses pour l’intelligence artificielle. Selon l’IIT, même une simulation parfaite d’un cerveau, neurone par neurone, synapse par synapse, ne serait pas forcément consciente (ou très peu) si elle s’exécute sur une architecture dont la structure causale intrinsèque diffère de celle du cerveau biologique. Le comportement serait identique, mais pas l’expérience.

En d’autres termes, l’IIT implique que des « quasi-zombies » sont possibles : des systèmes au comportement indiscernable du nôtre, mais dotés de niveaux de conscience très différents.

Une théorie controversée

Les propriétés étranges que je viens d’énoncer ne font pas que des heureux dans le petit monde des spécialistes de la conscience, et l’IIT a longtemps fait figure de théorie un peu fringe. Les choses ont pris des proportions plus importantes à l’occasion des publications du consortium COGITATE dont j’ai parlé plus haut, qui comparait certaines prédictions de l’IIT et de GNWT.

Ainsi un groupe d’une centaine de chercheurs, baptisé les « IIT-Concerned » a publié plusieurs lettres ouvertes visant à dénoncer l’IIT comme pseudo-science. J’ai lu notamment la dernière paru récemment dans Nature Neuroscience, et si certains arguments sont intéressants, je trouve la charge assez exagérée. En voyant la longue liste de la centaine de signataires qui s’offusquent de l’IIT, je ne peux pas m’empêcher de penser au livre Cent Auteurs contre Einstein publié en 1931 pour critiquer la théorie de la relativité générale…ce à quoi le grand Albert aurait répondu « Cent auteurs ? Si j’avais vraiment eu tort, un seul aurait suffit ! ». La comparaison a toutefois ses limites (Einstein avait raison, ce qui ne garantit rien pour l'IIT) mais elle illustre que le nombre de signataires n'est pas un argument scientifique en soi.

Parmi les critiques formulées par les IIT-Concerned, je trouve intéressant d’en noter quelques unes. Notamment le risque qu’ils voient de proposer une théorie quantitative pas encore mature, et qui pourrait alors être (mal) utilisée pour débattre de questions politiques et sociales importantes (comme l’éthique animale, le droit à l’avortement, la question de la conscience des IA…).

Une critique reliée et intéressante, c’est que les auteurs estiment que l’IIT bénéficie d’une visibilité trop importante auprès du grand public en regard de son statut scientifique réel. Cela fait pas mal de temps que j’ai entendu parler de l’IIT, et j’avoue que pour moi elle m’avait toujours paru être une sorte de théorie alternative un peu bizarre. Il y a quelques années, j’aurais pu comprendre cette position des IIT-Concerned qui s’inquiètent de la popularité de l’IIT auprès du grand public. Mais il me semble, notamment avec les résultats de COGITATE, que l’IIT a fini par mériter son statut parmi les théories raisonnables pour expliquer la conscience. Ça ne fait pas d’elle LA théorie dominante comme certains semblent s’en inquiéter, mais disons que les médias (et vulgarisateurs !) devraient pouvoir en parler comme d’une alternative plausible. (Et par souci d’équité, ça fait longtemps que je me dis qu’il faut que je fasse une vidéo sur GNWT…affaire à suivre !)

Les produits matriciels sont-ils conscients ?

Pour finir sur une note qui contraste avec cet enthousiasme, je voudrais mentionner un résultat intrigant démontré par Scott Aaronson, chercheur en informatique théorique et auteur d’un blog que j’aime beaucoup. Scott a en effet construit ce qui est pour lui un contre-exemple aux prétentions de l’IIT : un système en apparence « simple » (dont la dynamique est gérée par une matrice de Vandermonde) mais dont la valeur Φ peut être rendue arbitrairement grande (en augmentant la taille de la matrice).

Il en conclut qu’un système de portes logiques pourrait, si on en met suffisamment et qu’on les arrange comme il faut, posséder un Φ plus élevé qu’un cerveau humain. Pour lui, c’est un argument manifeste que l’IIT se trompe en postulant l’information intégrée comme condition nécessaire et suffisante pour définir la conscience. Scott écrit pour finir :

But let me end on a positive note. In my opinion, the fact that Integrated Information Theory is wrong—demonstrably wrong, for reasons that go to its core—puts it in something like the top 2% of all mathematical theories of consciousness ever proposed. Almost all competing theories of consciousness, it seems to me, have been so vague, fluffy, and malleable that they can only aspire to wrongness.

Il en a résulté un échange intéressant (mais que j’avoue ne pas avoir entièrement compris) avec le chercheur Guido Tononi, un des pères de l’IIT. Malgré tout, l’exemple de Scott Aaronson date d’il y a 10 ans, et je ne sais pas si l’objection est toujours valable dans les reformulations du cadre mathématique proposée plus récemment (voir notamment l’IIT 4.0).

Comme toujours, plus de recherches seront nécessaires pour continuer à évaluer les différentes théories de la conscience. L'IIT reste une théorie controversée, mais c'est précisément ce qui la rend intéressante : elle fait des prédictions, elle est mathématiquement formulée, et elle peut être mise à l'épreuve. Qu'elle survive ou non aux tests futurs, elle aura contribué à transformer la question de la conscience d'un mystère philosophique en un problème scientifique, et c'est peut-être déjà beaucoup !

Super intéressant, mais ai-je manqué quelque chose ? Je ne vois pas en quoi le problème difficile de la conscience est approché, encore moins égratigné. Personnellement j'en étais resté à une confortable (et vague) "propriété émergente" faite du grand nombre d'interactions, et de haut degré de récursivité interne (façon Édgar Morin dans "la connaissance de la connaissance"), mais j'ai compris récemment que même cela n'était pas vraiment satisfaisant. Aujourd'hui, j'aime bien penser que la conscience est quelque part le fruit d'un dialogue intérieur entre plusieurs instances (c'est l'idée d'âme opposable comme le pouce opposable, préhension, compréhension). Chez les personnes "split-brain" on observe des choses étonnantes avec ce qui ressemble à une instance qui sait (comprend) sans se rendre compte, et une autre qui se rend compte sans savoir (sans comprendre). Ce problème difficile a encore de beaux jours devant lui !

Article très intéressant et débat philosophique inhérent très actuel.

Je souhaite simplement corriger une coquille mathématique : « Pour un système constitué de N unités élémentaires, il y a 2^N partitions possibles » → 2^N parties possibles.

Le nombre de partitions d'un ensemble à n éléments est donné par les nombres de Bell (https://fr.wikipedia.org/wiki/Nombre_de_Bell) et ne se calcule que par une somme de série ou par récurrence.

Pour le reste, je serai ravi de lire d'ici quelques années la manière dont a évolué ces domaines scientifiques de la conscience, avec pourquoi pas l'émergence (haha) de nouvelles concurrentes sérieuses ;)

Merci pour tout David et bonnes fêtes !